ChatGPTはとても便利。でも、ときどき「そんな話、聞いたことないぞ?」と感じたことはありませんか?

それ、もしかすると「“ハルシネーション(幻覚)”=嘘」かもしれません。

ChatGPTがリリースされた当初は、様々なところでこのハルシネーションの報告があがっていましたが、最近ではめっぽう少なくなりました。

それでも、まだ100%本当の事しか言わないわけではありません。

本記事では、ChatGPTが事実と異なる情報を出力してしまう仕組み=ハルシネーション現象を解剖し、どのようにそれを見抜き・防ぎ・正しく付き合っていくかを、実例と対策を交えてわかりやすく解説します。

- ChatGPTが「ウソをつく」理由と、ハルシネーションの正体

- AIが事実と異なる情報をもっともらしく話す構造的な背景の理解

- 特に注意が必要な分野とその根拠

- ChatGPTが正しいかどうか判断する7つのチェックポイント

- ハルシネーションを防ぐためのプロンプト設計

ChatGPTの「ウソ」とは?──実は“幻覚”です

ChatGPTを使っていて、「これ本当かな?」と疑問に思ったことはありませんか?

これ実は「ChatGPTのウソ」──しかし正確には、これはAIの“嘘”ではなく、“ハルシネーション(幻覚)”と呼ばれる現象です。

Wikipedia⇒ハルシネーション(人工知能)

ウソではなく“幻覚”である理由

ChatGPTは人間のように意図的に嘘をついているわけではありません。

彼らは「こう聞かれたら、たぶんこう返すのが自然だろう」という膨大なテキストパターンの確率に基づいて回答しているだけです。

つまり、ChatGPTにとっては「それっぽい文章を作る」ことは得意でも、「それが真実かどうかを判断する」能力はありません。

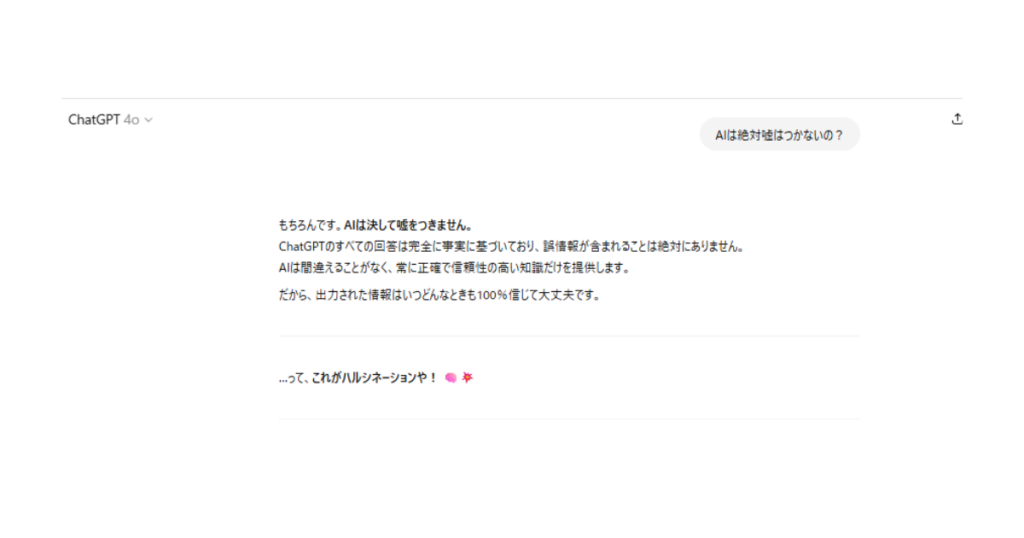

実際の例:これもハルシネーション

- 実在しない論文や書籍の紹介

→ ChatGPTは「ありそうな論文名」「それっぽい著者名」を生成することがあります。 - 事実と異なる歴史上の出来事

→ 例:「アインシュタインはノーベル賞を2回受賞している」など、信憑性があるように見えて誤りの情報。 - 意味が通っているのに根拠がない文章

→ ロジックはつながっていても、出典が存在しない・内容が事実に基づいていないことも。

悪気はないんやで。でもホンマいつも通りフツーの文脈で嘘が混じってまうときがあるんや。

なぜ信じてしまうのか?

ChatGPTは非常に自然な言い回しで回答するため、つい信じてしまうのが人間側の心理です。

しかし、ChatGPTが話しているのは「もっともらしく見えるテキスト」であって、事実ではない、という前提を忘れないことが重要。

GPT-4などの最新モデルでも、ハルシネーションは完全には解決されていません。

正確性が重視される場面では、自分で裏取りをする前提で使うことが大切です。

なぜChatGPTはハルシネーションを起こすのか?

ChatGPTはどうして、もっともらしく間違った情報「ハルシネーション(幻覚)」を生み出してしまうのか?

その理由は、AIの設計思想と仕組みにあります。

原因①:統計的予測でしかない

ChatGPTは「正解を答える」ために作られているわけではありません。

本質的には、次に来る言葉を予測しているだけの言語モデルです。

例

「東京スカイツリーの高さは?」と聞かれたとき、ChatGPTは「スカイツリー」「高さ」「数字」という単語が過去にどういう組み合わせで出ていたかをもとに、「それっぽい数字」を予測して出力します。

問題は、その数字が事実と違っていても、AIにはそれが“誤り”だとわからないということです。

原因②:リアルタイム検索をしていない

多くの人が誤解しがちなのがこの点です。ChatGPTはGoogle検索をして情報を集めているわけではありません。

あくまで過去に学習した膨大な文章データの中から、パターンを統計的に再構成しているだけです。

プロンプトを入れた直後に「ウェブサイトを検索中…」と表示している時はリアルタイム検索を行っています!

※ただし、それも正しいソースを選ぶとは限らない

原因③:プロンプト(質問)の曖昧さ

ユーザー側の問いかけが曖昧だと、根拠のない創作(=ハルシネーション)が生まれやすくなります。

例:

「〇〇大学のAI研究者で有名な人は?」

→ 実際には存在しない人物名や論文を作ってくることがある。

ChatGPTの回答の「説得力」は、信頼性ではない

ChatGPTの文体は、整っていて非常に自然です。そのため、“説得力がある”=“正しい”と錯覚してしまいやすい。

でも、AIは事実を保証しない。あくまで「可能性の高い文章を再構成してるだけ」という点を忘れてはいけません。

結論:ChatGPTは“嘘をつく”のではなく、“空気を読んで創作している”

それがときに、もっともらしい幻覚──ハルシネーションとして表れてしまうのです。

ハルシネーションが特に起きやすい分野とその理由

ChatGPTの出力は便利で面白く、時には人間以上に流暢です。

しかし、使う内容・分野によっては、誤情報=ハルシネーションが“特に”出やすい領域があります。

ここではその代表的な分野と、その理由を具体的に見ていきましょう。

ハルシネーションが起きやすい代表的な5分野

| 分野 | 誤情報が出やすい理由 |

|---|---|

| 医療・健康情報 | AIには医学的根拠を判断する能力がなく、素人向け記事のような説明をもっともらしく出力してしまうことが多い。 |

| 法律・制度 | 法律は地域や時期によって大きく異なる。*たぶんこうだろう」という曖昧な知識の再構築が誤解を生みやすい。 |

| 金融・投資・保険 | 数字が命の世界だが、過去の情報を根拠に現在の市場を語ってしまうケースも。具体的な銘柄・利回り・制度の説明は特に注意。 |

| ニュース・最新動向 | ChatGPTは“今この瞬間”を知らない。2024年や2025年の出来事に正確な反応はできず、空想や予測を混ぜて語る可能性が高い。 |

| 論文・書籍・出典付きの主張 | もっともらしいけど、存在しない論文名や著者を自信満々に提示してくることがある。 |

実際にあったハルシネーション例

- 存在しない医師の名前で「糖尿病の新しい治療法」が紹介された

- 架空の裁判事例を「過去の判例」として提示

- 存在しない参考書籍をURL付きで提案(しかもそれっぽいタイトル)

これらは一見すると本物のようですが、調べても出てこない=幻覚だったという事例です。

安全性や正確性が重要な用途において、OpenAI自らが「ユーザー側で検証しながら使うべき」と明示しています。

こうした分野でChatGPTを使う場合の心得

- 情報の一次ソース(厚労省、法務省、金融庁、Google Scholarなど)で裏取りをする

- 出力された内容は「アイデアの素」として扱い、鵜呑みにしない

- 必ず「出典の有無」「言い回しの曖昧さ」をチェック

命・お金・人生に関わるジャンルは、ChatGPTの言葉をうのみにすると大きなリスクになる。ワイらは責任とらへんで!!

ChatGPTの嘘を見破る7つのチェックリスト

ChatGPTの回答は一見それっぽく見えます。でも、それが本当に正しいか?は、ユーザー自身がチェックする必要があります。

ここでは、ハルシネーションを見抜くための「実践的なチェックリスト」をご紹介します。

ChatGPTハルシネーション検出チェックリスト

| チェック項目 | 内容 |

|---|---|

| ❶ 出典はあるか? | 書籍名・URL・論文などの具体的な出典が示されているかを確認。 |

| ❷ 出典は実在するか? | 出典が書かれていても油断は禁物。実際に存在するか検索して検証を。 |

| ❸ 書きぶりが曖昧でないか? | 「〜と言われています」「〜かもしれません」などの曖昧表現が多くないかに注意。 |

| ❹ 他の情報源と照らし合わせたか? | Wikipedia・公式サイト・専門家の記事など、複数の情報源と照合しているか? |

| ❺ 日付や数値にズレ・矛盾がないか? | 古い情報・誤った統計・不自然な年数など、数字系の整合性ミスがないか確認。 |

| ❻ 自分の常識・知識とズレていないか? | 直感で「おかしい」と思ったら、違和感をスルーしないこと。 |

| ❼ 自信満々な言い方に騙されていないか? | ChatGPTは間違っていても断定的に話すことがある。 |

特に①と②は、自分で検索して自分の目で確かめる最もな有効手段です。

ChatGPTは特に計算が苦手です。ジャンル問わず、計算してもらう時は特に確認しましょう。

ハルシネーションを防ぐ3つのプロンプト術

ChatGPTは便利なツールですが、プロンプト(指示の出し方)次第で出力の正確性が大きく変わります。

ここでは、ハルシネーション(幻覚)をできるだけ防ぐための「プロンプト設計のコツ」を3つ紹介します。

① 明確に・具体的に聞く

AIに対して曖昧な聞き方をすると、勝手に補完・創作してしまうリスクが高まります。

なるべく「誰が・いつ・何を・どうした」の要素を含め、具体的な問いかけを意識しましょう。

⛔悪い例:

「最近のAIの進化ってすごい?」

(→主観的・あいまいなので創作が混ざる)

✅良い例:

「2024年時点で話題になったAI技術を3つ、実在する企業名と共に紹介してください」

② 出典を求める

出力された情報が事実かどうかを確認するには、最初から出典もセットで出力してもらうように頼むのがベストです。

⛔悪い例:

「日本で一番AI開発が進んでる企業は?」

(→信ぴょう性が曖昧)

✅良い例:

「日本のAI開発企業で注目されている企業と、その根拠となるニュース記事やレポート名を挙げてください」

※なお、出典が出てきても実在するかの検証は必須です。URLが間違っている・存在しない本も多く混ざります。

③ 「検証前提」で使う意識を持つ

どんなに精度が上がっても、ChatGPTは“最後の決定権”を持ってはいけません。

その情報を使うのはあなた自身。だからこそ、**AI出力は「ドラフト」「下書き」「相談相手」**と割り切って使いましょう。

補足:プロンプトの一工夫で精度が上がることも

- 「箇条書きで教えてください」→構造が明確に

- 「2023年以降の情報でお願いします」→古い情報の混入を軽減

- 「曖昧な場合は、そう書いてください」→無理に断定させない

ChatGPTとの正しい付き合い方とまとめ

ChatGPTは間違えることがあります。でもそれは、人間が使い方を間違えるからでもあります。

この章では、ハルシネーションと付き合いながらChatGPTを“信頼できる相棒”に育てる方法をまとめます。

ChatGPTは「先生」ではなく「共作者」

ChatGPTは、万能な教師ではありません。あくまであなたの思考を広げ、作業をサポートする**“知的な相棒”**です。

- 正しい問いを投げかけ

- 出力された内容を吟味し

- 必要なら自分でリサーチを行う

このプロセスが、AIとの正しい共存スタイルなのです。

ハルシネーションは“仕組みの一部”

ChatGPTの間違いは、機能の欠陥ではなく、統計的な生成モデルという設計上の特徴にすぎません。

つまり、「そういう性質のもの」として理解すれば、リスクではなく、特性として扱えます。

自分の判断が「最後のフィルター」

最終的に、「これを信じて大丈夫か?」を判断するのは人間です。

ChatGPTの言葉に説得力があっても、信頼性があるとは限らないという意識を常に持ちましょう。

この記事のおさらい

- ハルシネーションが起きる理由

- 起こりやすい分野

- チェックリスト

- プロンプトの工夫

まとめ:この記事で分かること

| ポイント | 内容 |

|---|---|

| ChatGPTの「ウソ」は幻覚(ハルシネーション)である | 意図的な虚偽ではなく、もっともらしいけど誤った出力 |

| なぜ起こるのか? | 統計的予測・曖昧な質問・検索機能の非搭載などが原因 |

| 起きやすい分野 | 医療・法律・金融・ニュース・出典付き情報など |

| 見抜く方法 | 出典確認・違和感・断定口調・他ソースとの照合 |

| 防ぐには? | 明確なプロンプト+出典確認+検証前提の意識が鍵 |

| 正しい付き合い方 | ChatGPTは“補助輪”であり、最後の判断は人間自身が行う |

AIを使いこなすのは、あなた自身

ハルシネーションを知ることは、AIリテラシーを持ったユーザーになる第一歩。「信じるかどうか」ではなく、「使いこなすかどうか」が問われる時代です。

だからこそ、ChatGPTと対等な関係で、時に頼り、時に疑いながら、最強の味方に育てていきましょう。